神经信息处理系统大会(Neural Information Processing Systems, NeurIPS)是国际人工智能顶会之一,今天为大家介绍通用视觉团队的中稿论文之一Foundation Model is Efficient Multimodal Multitask Model Selector,一作为我团队与上海交通大学的2023级联培博士孟繁青同学,指导老师 罗平教授,邵文琪博士。

论文:

代码(点击“阅读原文”直达):

https://github.com/OpenGVLab/Multitask-Model-Selector

我们的贡献主要如下

-

我们提出了一种通用的预训练模型的下游任务性能估计技术,即高效多任务模型选择器(EMMS)。EMMS配备了基础模型提供的统一标签嵌入和简单的加权线性平方回归 (WLSR),可以快速、有效地评估预训练模型在各种下游任务中的可迁移性。

-

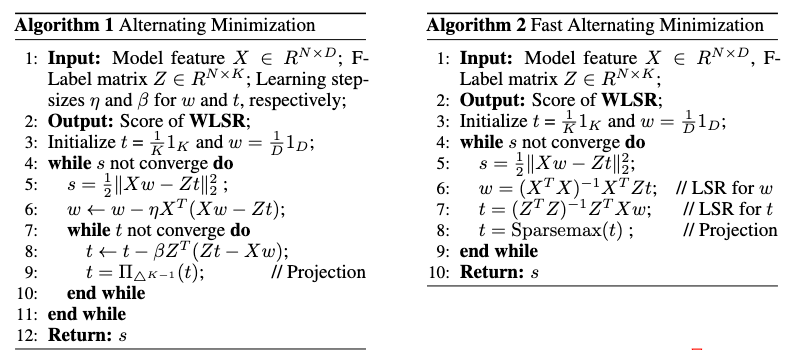

我们提出了一种新颖的交替最小化算法,有效地求解WLSR,我们证明了该算法的收敛性并提供了算法的加速版本。

-

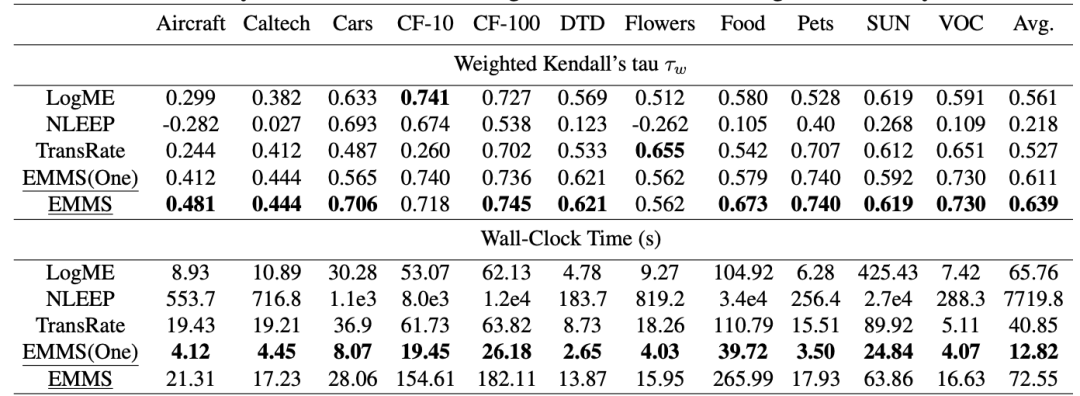

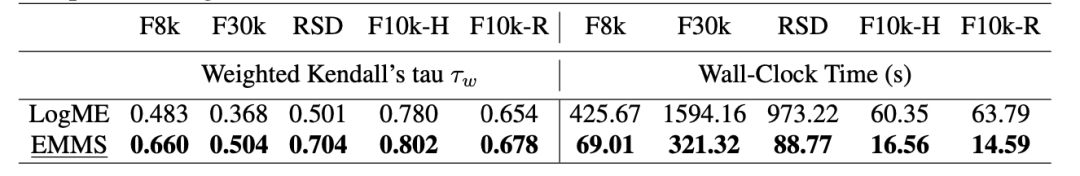

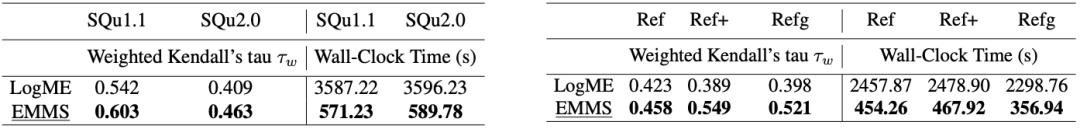

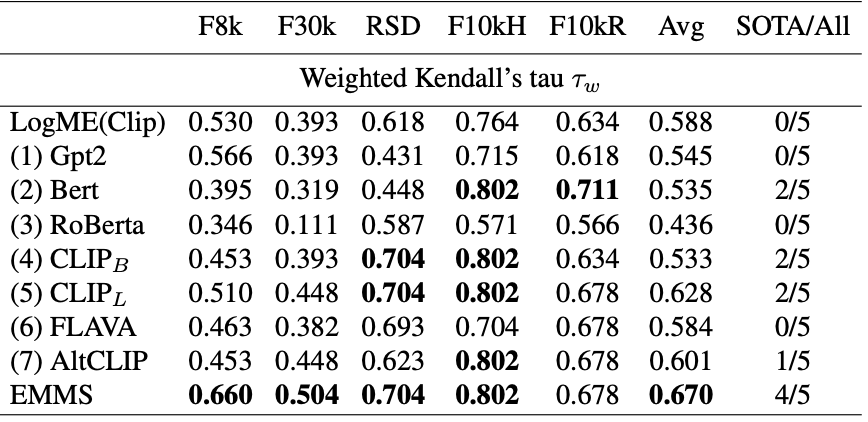

对 24 个数据集的 5 个下游任务进行的广泛实验证明了EMMS的有效性。具体来说,EMMS 在图像识别,视觉定位任务,图像描述,视觉问答和文本问答方面实现了 9.0%、26.3%、20.1%、54.8%、12.2% 的性能提升,同时与通过我们的标签嵌入增强的最先进方法LogME[4]相比,带来 5.13×, 6.29×, 3.59×, 6.19× 和 5.66× 的加速。

-

相比于其他方法,EMMS首次实现了通用的多任务多模态模型优选算法。

方法详述

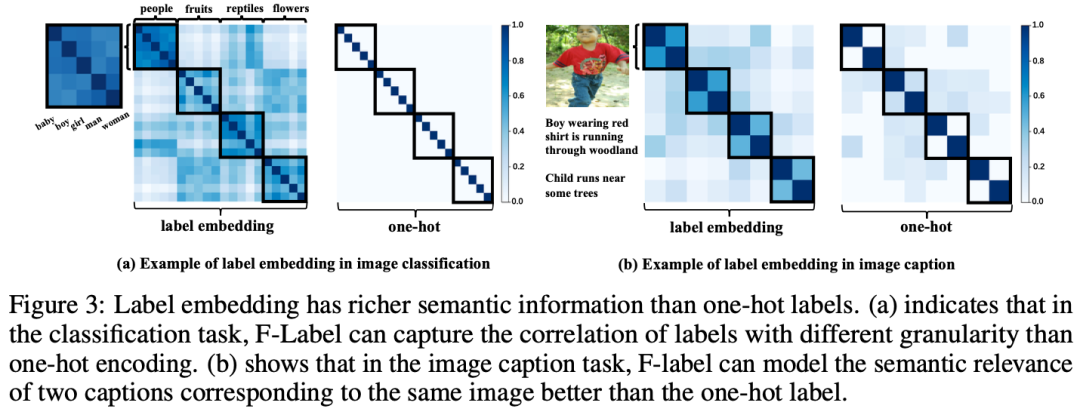

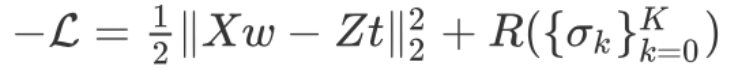

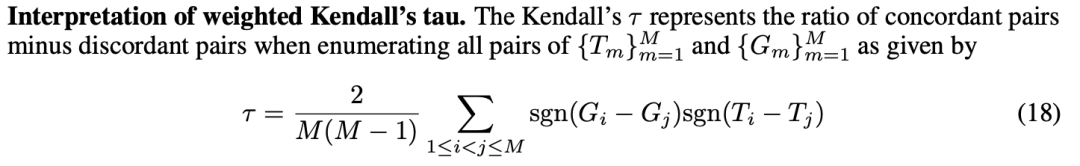

在本节中,我们介绍高效多任务模型选择器(EMMS)。我们认为统一多任务模型优选问题的关键是统一不同任务中的标签格式,为了克服标签格式多样化的困难,EMMS 采用基础模型将各种标签转换为的统一标签嵌入。通过将多个基础模型提供的标签嵌入视为真实标签的噪声版本,EMMS 可以在简单加权线性平方回归(WLSR)框架下计算可转移性度量。同时我们设计了一种交替最小化算法来有效地求解 WLSR。

标签嵌入

加权线性回归

求解算法以及加速算法

实验结果

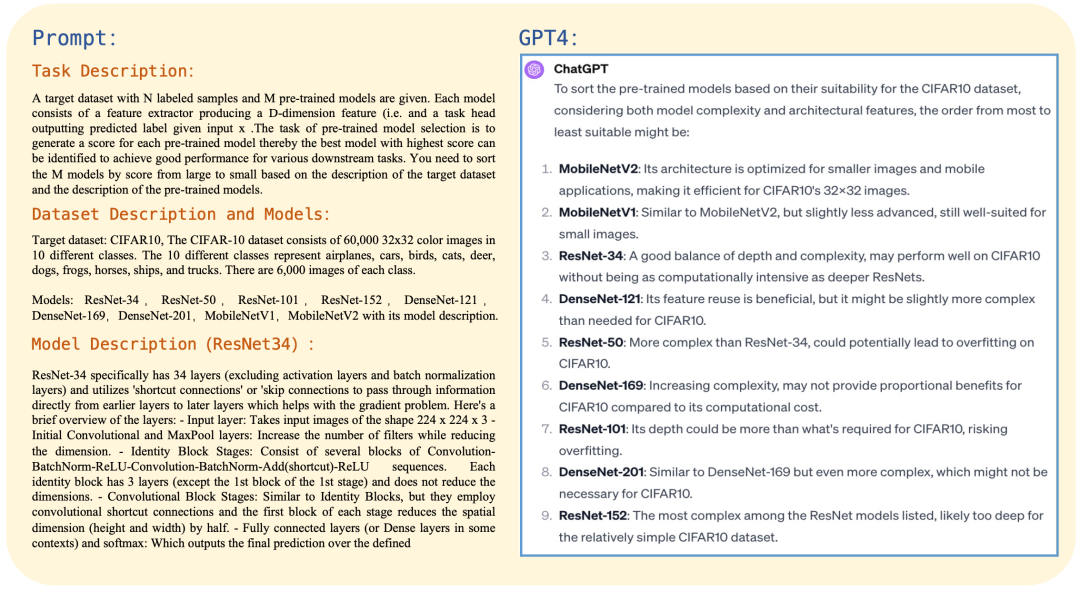

与GPT4对比

总结

https://arxiv.org/abs/2308.06262

本篇文章来源于微信公众号: 医工学人